Métricas F1, Recall y Precisión – Primera parte

Qué tan bueno es un sistema antifraude? tan bueno como lo sean sus métricas. En este artículo exploraremos el mundo de la evaluación de los modelos de inteligencia artificial que analizan y generan contenido semántico (LLM) para detectar y prevenir el fraude. Pondremos a prueba y compararemos una Inteligencia Artificial disponible al público (OpenAI GPT-4) y una privada (FraudGPT 7).

Las métricas F1, Recall y Precision se usan para evaluar la efectividad de los modelos de inteligencia artificial en tareas binarias de clasificación, como por ejemplo, detectar si existe fraude o no.

En NOFRAUD hemos llevado a cabo un estudio donde ponemos a prueba las principales IA disponibles al público y las comparamos con la nuestra (FraudGPT). Este estudio tiene como propósito demostrar la superioridad de nuestro modelo para prevenir y detectar fraudes frente a los modelos genéricos.

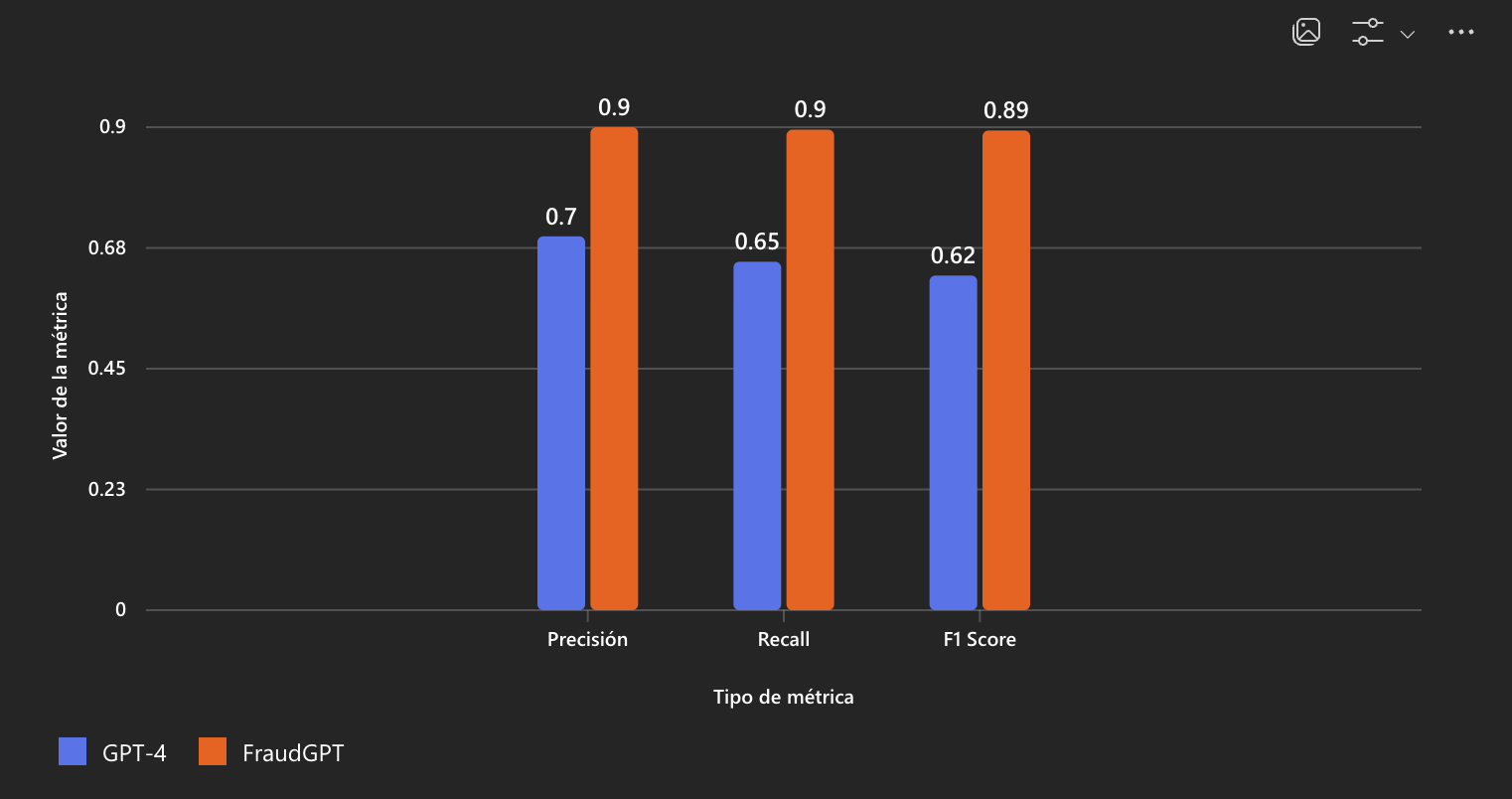

Para introducirnos en el tema, que mejor que empezar con esta gráfica:

Qué estamos viendo aquí?, vamos paso a paso:

- Dos modelos que son comparados, OpenAI GPT-4 y FraudGPT 7, respecto a un set de evaluación, donde se les pidió a los dos modelos, con los mismos datos de prueba, que resolvieran un caso como fraude o no. Se les pidió evaluar 200 casos reales, de los cuales la mitad eran casos probados de fraude y la otra mitad no. El trabajo para los LLM fue arduo, porque muchos de los casos no eran explícitos del tipo “me voy a robar la plata” y algunos eran más técnicos y sutiles, donde el fraude de cuello blanco, azul y morado se ven de maneras distintas.

- Se ve a simple vista que GPT-4 se queda muy por debajo de FraudGPT en tres categorías: F1, Recall y Precision. Más adelante veremos qué significa esto de una forma mas detallada.

Enfoquémonos entonces en el significado de las métricas y vamos desglosando los detalles más íntimos de esta gráfica.

Evaluación de la inteligencia artificial

La mejor forma de evaluar un modelo que esté destinado a prevenir y detectar el fraude, es a través de un conjunto de métricas que ponen a prueba la capacidad de un modelo en identificar correctamente un caso de fraude de uno que no lo es:

- La métrica Precision, indica qué proporción de las predicciones positivas del modelo fueron realmente correctas. Ejemplo: si el modelo dice que 10 comportamientos son anti éticos y solo 7 realmente lo son, la precisión es 70%.

- La métrica Recall, mide cuántos de los casos positivos reales fueron detectados por el modelo. Ejemplo: Si hay 20 comportamientos anti éticos y el modelo detecta 15, el recall es 75%.

- La métrica F1, es la media armónica entre Precision y Recall. Sirve para balancear ambos aspectos cuando hay un desequilibrio entre clases o cuando es importante tanto evitar falsos positivos como falsos negativos.

Se puede decir que un modelo que esté por debajo del 65% en éstas métricas, no es apto para prevenir o detectar el fraude y por más impresionante que parezca el modelo, se equivocará mucho diciendo que sí es fraude y al mismo tiempo dejará pasar muchos casos que sí lo son y los catalogará como negativos.

Pero por qué sucede esto con uno de los modelos más potentes del mundo como lo es GPT-4 de OpenAI ?, la respuesta es más sencilla de lo que parece: porque GPT-4 no fue entrenado en esa casuística específica del comportamiento humano en ambiente corporativo y además, a GPT-4 no le gusta el contenido nocivo y puede negarse a veces a analizar un comportamiento criminal.

Por qué FraudGPT es mejor

Son varios los aspectos que hacen que nuestra IA sea mejor que GPT-4:

- Datos privilegiados: nosotros hemos reunido más de 10mil casos reales de fraude durante más de 12 años que llevamos en el mercado. Hemos logrado curar estos datos, convertirlos en casuísticas y crear un dataset que ningún otra empresa tiene en el mundo.

- Entrenamiento: le enseñamos a un modelo fundacional a reconocer y aprender los patrones de las más de 10mil casuísticas de fraude, pero también le enseñamos otras 10mil casuísticas de comportamiento que no lo son, logrando un balance perfecto entre positivos y negativos.

- Potencia computacional: hemos implementado nuestra propia granja de GPUs donde hemos llevado a cabo los entrenamientos. Obtener un modelo superior a GPT-4 nos tomó aproximadamente 8 meses.

FraudGPT es un modelo de lenguaje natural (LLM) que logró obtener excelentes métricas para ambos casos, la detección de verdaderos positivos y la identificación de verdaderos negativos, logrando minimizar al máximo los falsos positivos y falsos negativos.

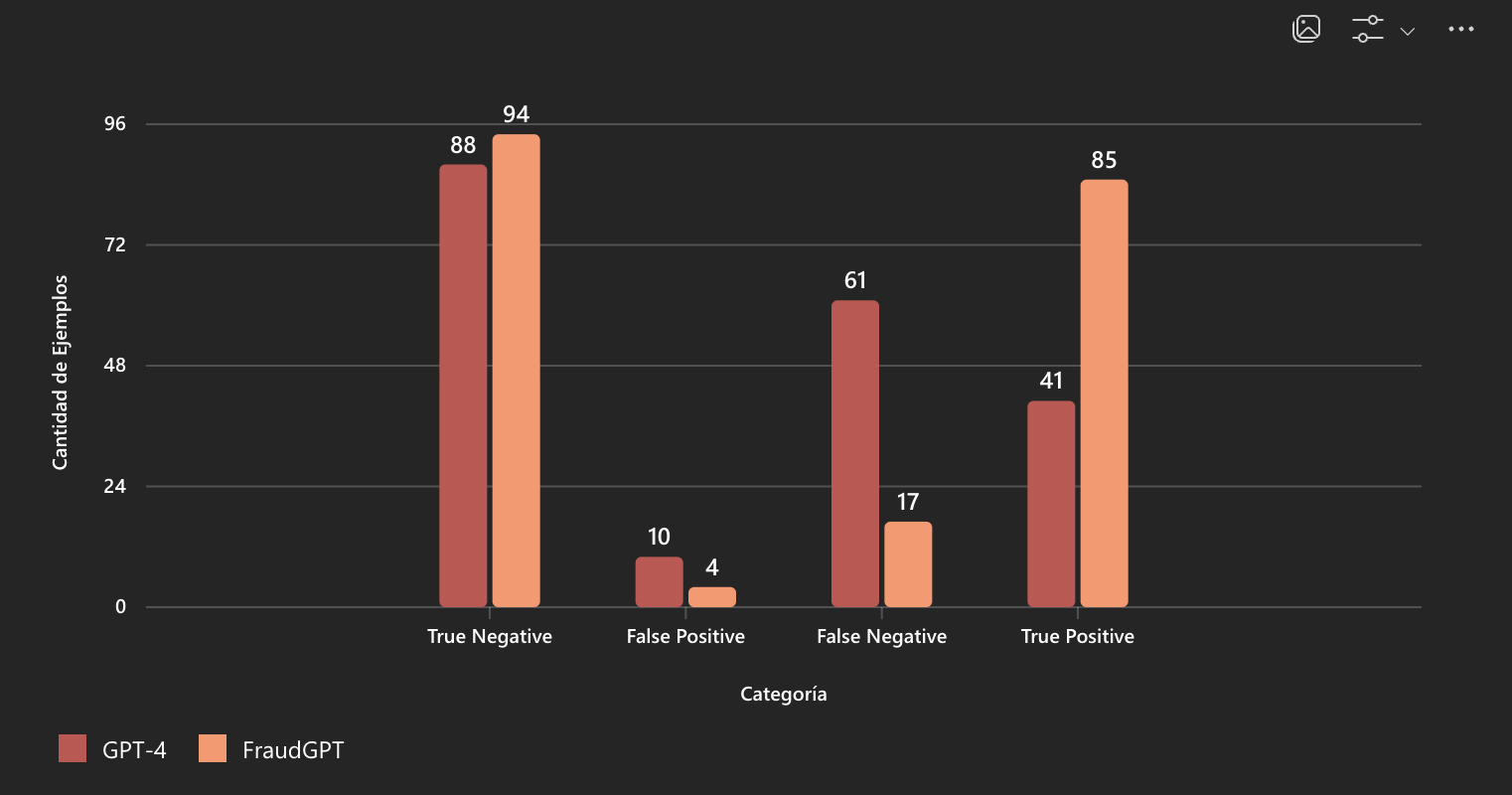

La matriz de confusión

La matriz de confusión es otra herramienta que se utiliza para evaluar el rendimiento de un modelo de clasificación. Muestra cómo se distribuyen las predicciones del modelo en relación con las verdaderas etiquetas. Se compone de cuatro elementos:

- Verdaderos Positivos (TP): Casos positivos correctamente clasificados.

- Verdaderos Negativos (TN): Casos negativos correctamente clasificados.

- Falsos Positivos (FP): Casos negativos clasificados erróneamente como positivos.

- Falsos Negativos (FN): Casos positivos clasificados erróneamente como negativos.

En este punto es donde tiene relevancia el set de evaluación Al principio mencionamos que para este test habíamos usado 200 casos para poner a prueba la potencia y capacidad de los modelos y el resultado de esas pruebas se verán ahora en algo que llamamos la matriz de confusión:

Esta gráfica la podemos interpretar de la siguiente manera:

- FraudGPT tiene muchos más True Positives (85) que GPT-4 (41), lo que indica que detecta mejor los casos positivos de fraude.

- GPT-4 tiene más False Negatives (61), lo que significa que falla más al detectar los casos positivos de fraude.

- Ambos modelos tienen buen desempeño en los True Negatives, pero FraudGPT muestra un 6% de superioridad en la detección de casos que NO son fraude.

- FraudGPT generó menos falsos positivos (4) que GPT-4 (10).

En términos de confiabilidad, FraudGPT es mucho mejor reduciendo falsos positivos y generando verdaderos positivos.

Resultados finales

Basado en las métricas macro, el modelo FraudGPT supera a GPT-4 en los siguientes porcentajes:

- Precisión Macro: mejora del 29.21%

- Recall Macro: mejora del 37.85%

- F1 Score Macro: mejora del 43.35%

El promedio total de mejora: 36.80%

Esto indica que, en términos generales, FraudGPT es aproximadamente un 37% mejor que GPT-4 en tareas de clasificación binaria para detección de comportamientos anti éticos, considerando precisión, cobertura y balance entre ambas.

Continúe leyendo …

Siga leyendo la segunda parte: Un Dataset privilegiado

Acerca de NOFRAUD

NOFRAUD es la compañía que desarrolla el software antifraude The Fraud Explorer y apoya a personas y empresas a enfrentar y solucionar sus retos en materia de fraude interno, corrupción y abuso corporativo. NOFRAUD ha creado la base de datos conductual de actos deshonestos más grande del mundo en Español e Inglés, que sirve para que la inteligencia artificial encuentre patrones sospechosos de corrupción al interior de las organizaciones.

Mejoramos la capacidad de las organizaciones incrementando sus beneficios, arrebatándole a los perpetradores la posibilidad de afectar negativamente los ingresos a través del fraude, la corrupción, el abuso corporativo y la generación de ambientes tóxicos.

Contacte conmigo en » jrios@nofraud.la y Visítenos en » www.nofraud.la.