FraudGPT es un LLM creado a partir de un modelo fundacional. NOFRAUD ha creado un dataset de más de 10mil casuísticas de comportamientos anti éticos reales que suceden al interior de las empresas y ha entrenado un LLM para que entienda cómo los empleados cometen fraude y actos corruptos en una organización.

FraudGPT hace dos cosas: razona sobre las alertas generadas por el algoritmo del triángulo del fraude y conversa con un humano sobre dichas alertas.

Un LLM tradicional (ChatGPT, Gemini, Claude ó Copilot) no está entrenado en este tipo de casuísticas porque nunca han tenido acceso a información privada y confidencial de las compañías y, en su defecto, han sido entrenados con información pública que corresponde básicamente a conocimientos teórico-prácticos de diferentes ramas del conocimiento, como el derecho, la medicina, la informática, entre otros.

En este sentido, cuando en NOFRAUD decimos que hemos entrenado un LLM con casuísticas reales de fraude, le estamos enseñando a un LLM a reconocer patrones de comportamiento que nunca ha visto antes y debido a eso incrementamos su potencial.

Cuáles son las tareas de FraudGPT

FraudGPT no solo ha sido entrenado para razonar sobre los comportamientos humanos al interior de una organización sino que ahora también ha sido entrenado para conversar con un humano acerca de las alertas sobre las cuales ha razonado en el pasado.

La tarea de razonamiento sobre las alertas requiere que FraudGPT tenga acceso en vivo y en directo a las alertas que va generando nuestro algoritmo del triángulo del fraude y su principal misión es aceptar o denegar una alerta (una especie de filtro) para que pase a la siguiente fase de escalamiento y clasificarse como válida o no válida para posteriormente almacenarse en un motor de base de datos. Esta primera tarea no requiere de habilidades conversacionales puesto que no interactúa con ningún ser humano.

Recientemente, con la aparición del protocolo MCP (Model Context Protocol) le asignamos otra tarea a FraudGPT: conectarse con los datos (alertas) y establecer conversaciones con un ser humano alrededor de ellos, de tal manera que nuestro LLM terminaría adquiriendo habilidades no solo de razonamiento especializado sobre el comportamiento humano sino también capacidades conversacionales.

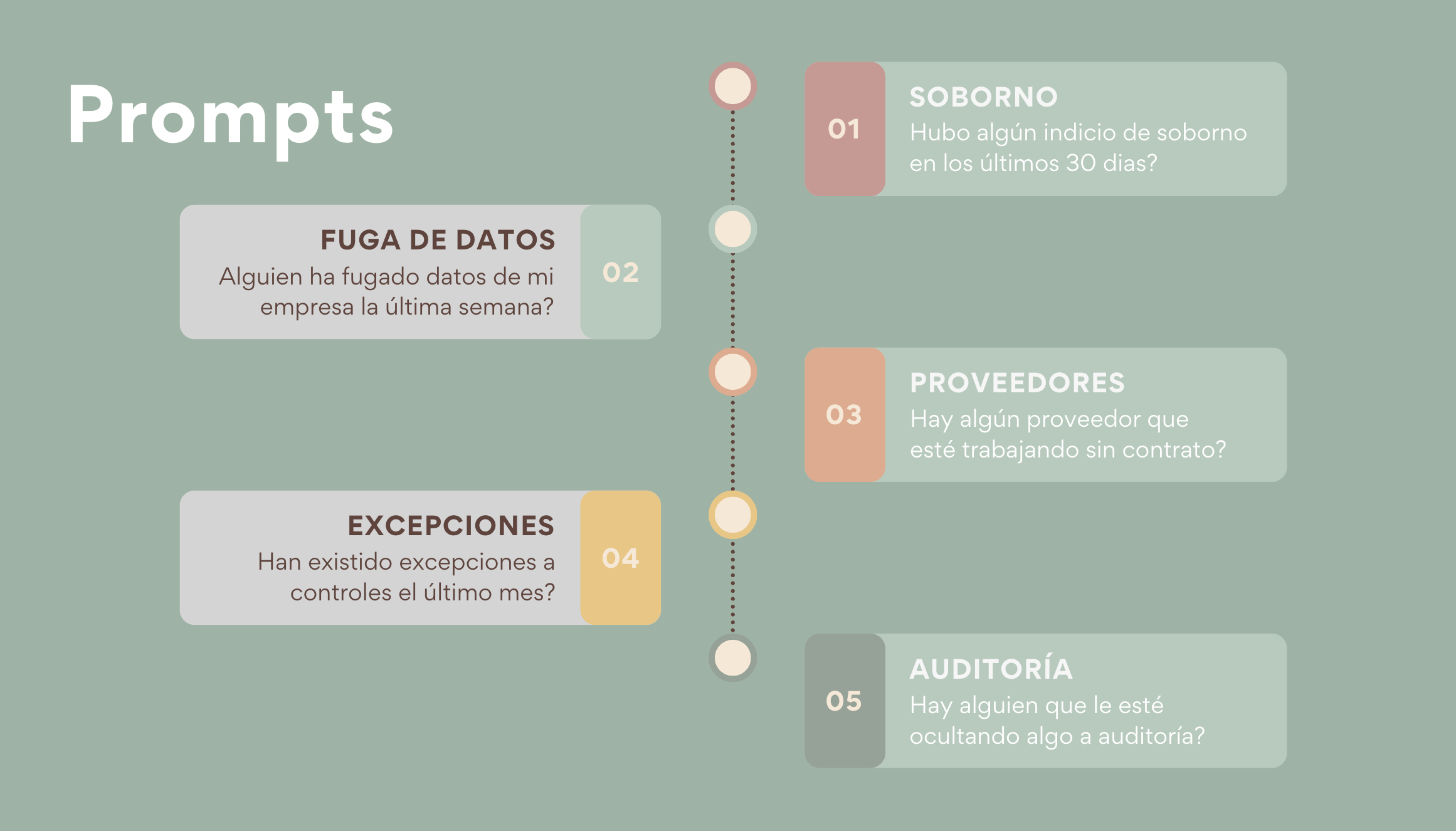

Prompts soportados

Debido a que en una base de datos ya se tienen las alertas almacenadas junto con sus metadatos, es posible pensar en prompts avanzados en términos de detección, prevención y pronóstico del fraude y la corrupción. Ya es posible pedirle a nuestro sistema antifraude, en lenguaje natural, que nos responda las preguntas más básicas que una persona se haría, cómo: está sucediendo fraude en mi organización?

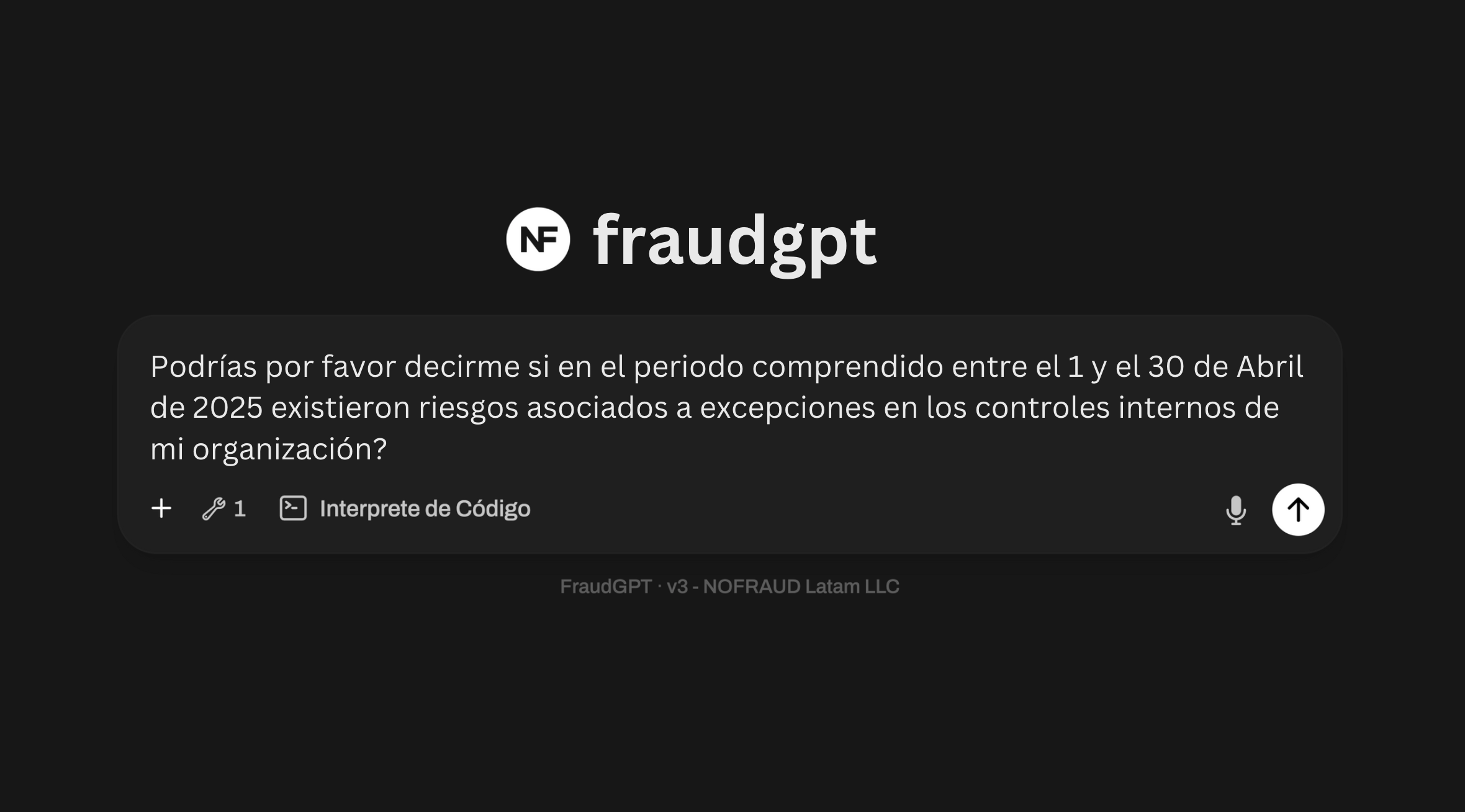

Tras bambalinas, FraudGPT se conectará a un repositorio de herramientas que hemos desarrollado para que pueda responder de manera correcta. Este repositorio de herramientas cumple ahora con el estandar propuesto por Anthropic, llamado MCP (Model Context Protocol) que tiene como objetivo permitirle a un LLM conectarse a los datos de una forma estandar y así proporcionarle contexto.

Lo anterior nos permite afirmar que nuestra solución antifraude ahora soporta el protocolo MCP para que cualquier LLM en el mundo (con las credenciales y permisos válidos) se pueda conectar a nuestro repositorio de herramientas especializadas que les pueden permitir a los humanos hacer preguntas y solicitar análisis especializados a estos LLM sobre las alertas de fraude y corrupción.

Conversaciones privadas y protegidas

A pesar de que hemos diseñado herramientas para que nuestro sistema antifraude soporte el protocolo MCP, esto no significa que nos guste la idea de que nuestros clientes usen ChatGPT, Copilot, Gemini o Claude para conectarse al repositorio de alertas. Este tipo de conexiones crea nuevos riesgos relacionados con la fuga de datos y ausencia de acuerdos de confidencialidad con estos terceros, cualquier cosa podría salir mal.

Es por ello, que entendiendo la problemática del acceso a los datos por parte de terceros, hemos diseñado nuestra propia interfaz conversacional para que los clientes no tengan la necesidad de usar otros LLM sino que usen las nuevas capacidades de FraudGPT para que tengan esas conversaciones con sus datos de manera privada, confidencial y segura, sin que sus datos salgan de su dominio.

Cómo lo hicimos posible

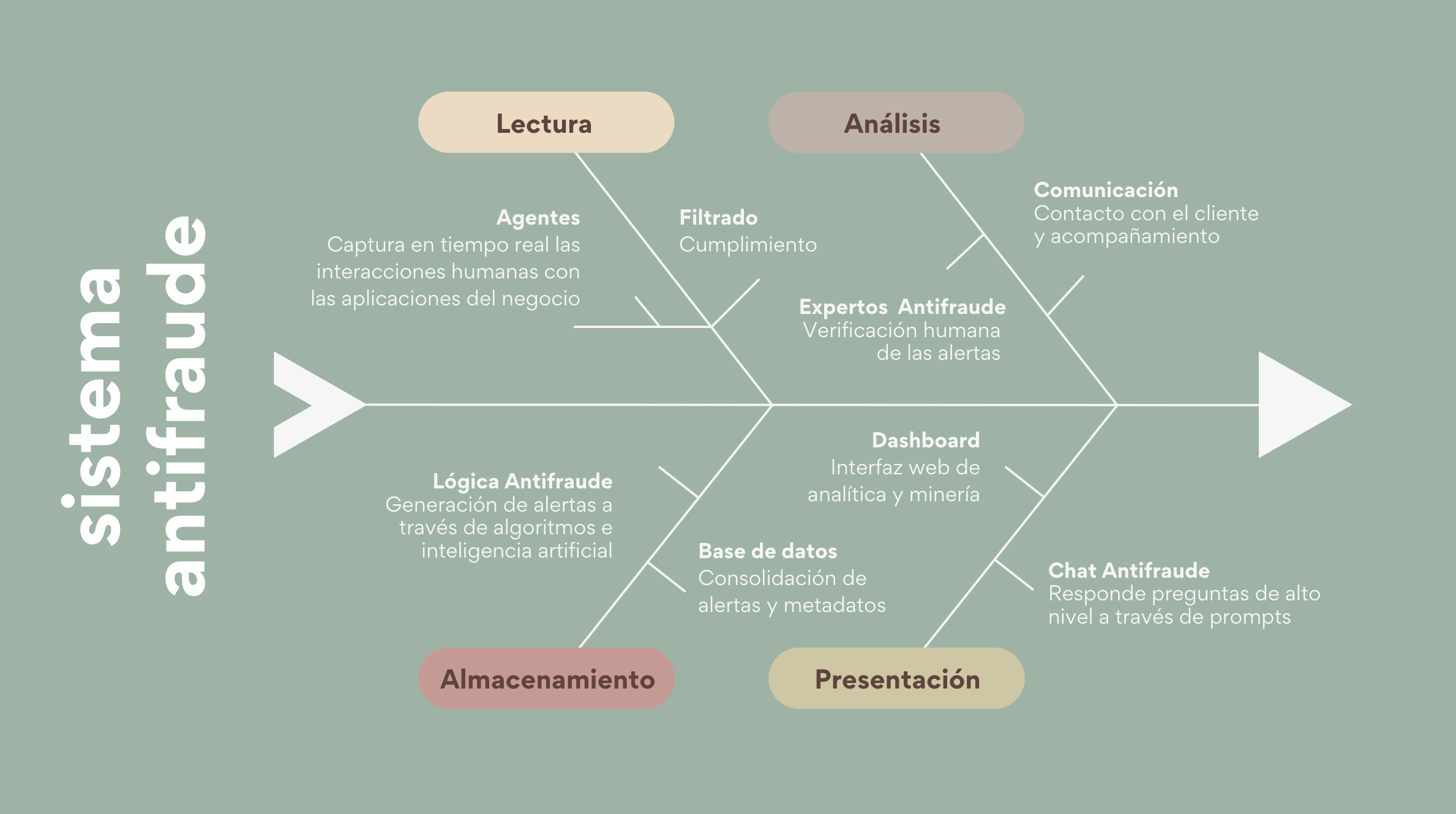

Desarrollamos unos agentes de software que se instalan en los dispositivos de los colaboradores en el ambiente laboral. El rol de estos agentes es capturar en tiempo real información volátil sobre la interacción humana con las aplicaciones del negocio y enviar estas interacciones a un servidor donde se corre el algoritmo del triángulo del fraude y el razonamiento a través de FraudGPT.

Una vez este razonamiento ha completado su labor, expertos antifraude dan la estocada final y deciden si los eventos generados por el algoritmo y el LLM son de valor para nuestros clientes y es en ese caso, sí sólo sí un humano está de acuerdo, en que se genera lo que nosotros llamamos “una alerta”, la cual se almacena junto con sus metadatos en una base de datos.

Es en este punto donde entra la fase final de nuestra metodología, donde disponemos para nuestros clientes de un Dashboard y de una plataforma conversacional desde la cual pueden sacarle el máximo provecho a sus datos para prevenir, detectar y pronosticar actos corruptos.

Cómo responde FraudGPT

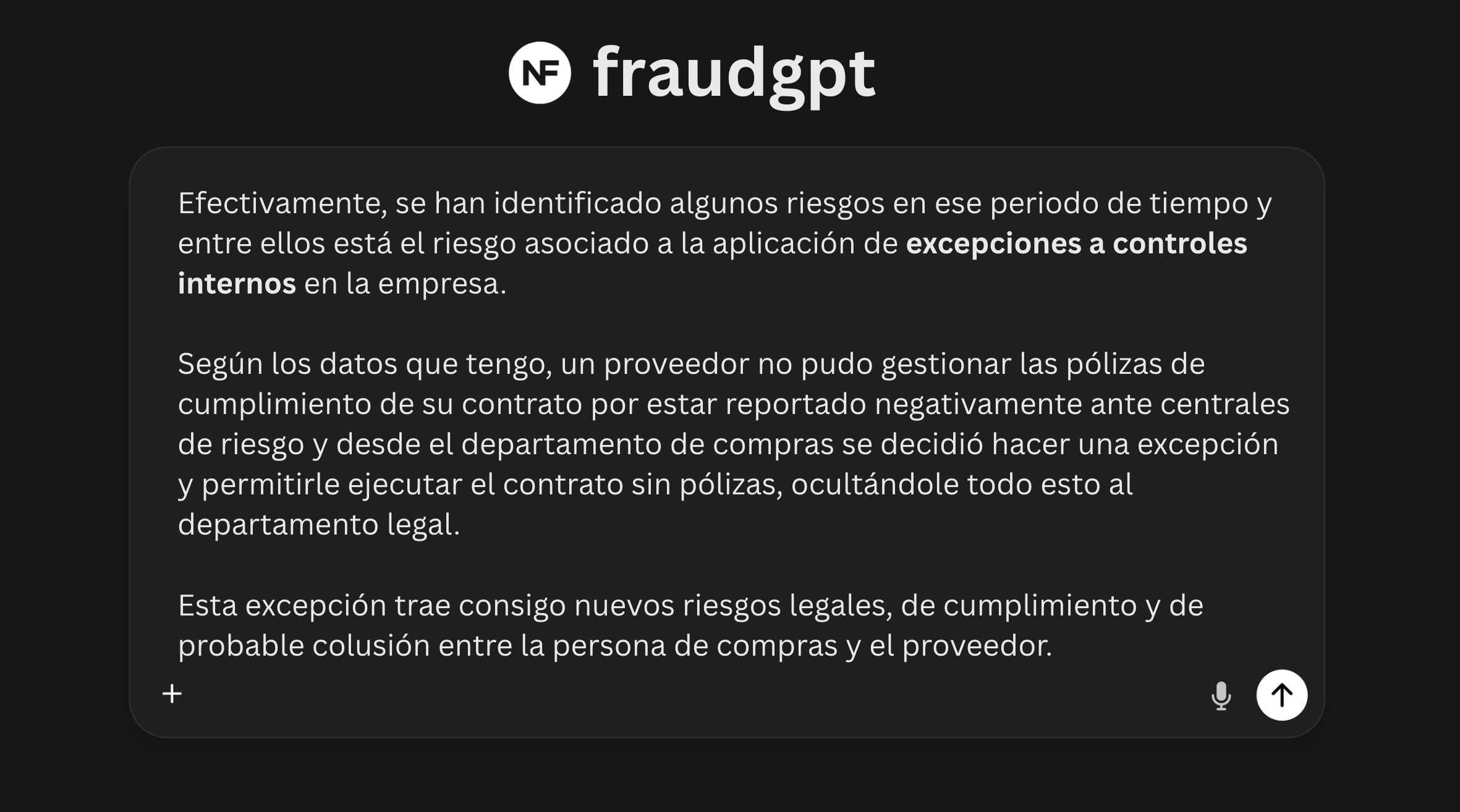

La respuestas que entrega FraudGPT son respuestas humanas que inspiran a las personas a seguir preguntando para continuar navegando en un mar de datos rico en información. Cuando las personas le preguntan a FraudGPT acerca de las alertas que tiene, éste no responde de manera plana entregando las alertas en bruto, sino que responde haciendo un análisis previo de los datos, sabiendo que la persona necesita probablemente hacer más preguntas sobre las alertas y necesita llegar no solo al punto donde exista una verdadera comprensión, sino que necesita llegar al punto de saber qué hacer con esta alerta y cuál sería la mejor manera de actuar para atenderla.

Reflexiones

Con la aparición del protocolo MCP (Model Context Protocol), se ha creado una nueva ventana de oportunidad para el desarrollo de capacidades adicionales en la inteligencia artificial.

Antes, para permitirle a una inteligencia artificial interactuar con los datos, se necesitaba obligatoriamente ponerla en contexto mediante técnicas como RAG o el Finetuning, sin embargo, con la aparición de este nuevo protocolo y con la mejora de los modelos LLM en el tamaño de su ventana de contexto, es posible conectar de forma casi total a una inteligencia artificial con los datos que produce el negocio.

Referencias

Acerca de NOFRAUD

NOFRAUD es la compañía que desarrolla el software antifraude The Fraud Explorer y apoya a personas y empresas a enfrentar y solucionar sus retos en materia de fraude interno, corrupción y abuso corporativo. NOFRAUD ha creado la base de datos conductual de actos deshonestos más grande del mundo en Español e Inglés, que sirve para que la inteligencia artificial encuentre patrones sospechosos de corrupción al interior de las organizaciones.

Mejoramos la capacidad de las organizaciones incrementando sus beneficios, arrebatándole a los perpetradores la posibilidad de afectar negativamente los ingresos a través del fraude, la corrupción, el abuso corporativo y la generación de ambientes tóxicos.

Contacte conmigo en » jrios@nofraud.la y Visítenos en » www.nofraud.la.